اكتشف باحثون من جامعة تشجيانغ الصينية شيئًا مثيرًا للاهتمام للغاية، وهو أن المساعدين الأذكياء في الهواتف المحمولة (في هذه الحالة Siri و Alexa) يمكن مهاجمتهم بطريقة بسيطة جدًا دون أن يكون لدى صاحب الجهاز المهاجم أي فكرة عن ذلك. الهجمات الموجهة بالموجات فوق الصوتية غير مسموعة للأذن البشرية، لكن الميكروفون الموجود في جهازك يمكنه اكتشافها، وكما تبين، يمكن إصدار أمر بها في كثير من الحالات.

يمكن ان تكون اثار اهتمامك

تسمى طريقة الهجوم هذه "DolphinAttack" وتعمل على مبدأ بسيط للغاية. أولاً، من الضروري تحويل الأوامر الصوتية البشرية إلى ترددات فوق صوتية (نطاق 20 هرتز وما فوق) ثم إرسال هذه الأوامر إلى الجهاز المستهدف. كل ما هو مطلوب لنقل الصوت بنجاح هو مكبر صوت متصل بمضخم صوت صغير ووحدة فك ترميز بالموجات فوق الصوتية. بفضل الميكروفون الحساس الموجود في الجهاز الذي تمت مهاجمته، يتم التعرف على الأوامر ويأخذها الهاتف/الجهاز اللوحي كأوامر صوتية كلاسيكية لمالكه.

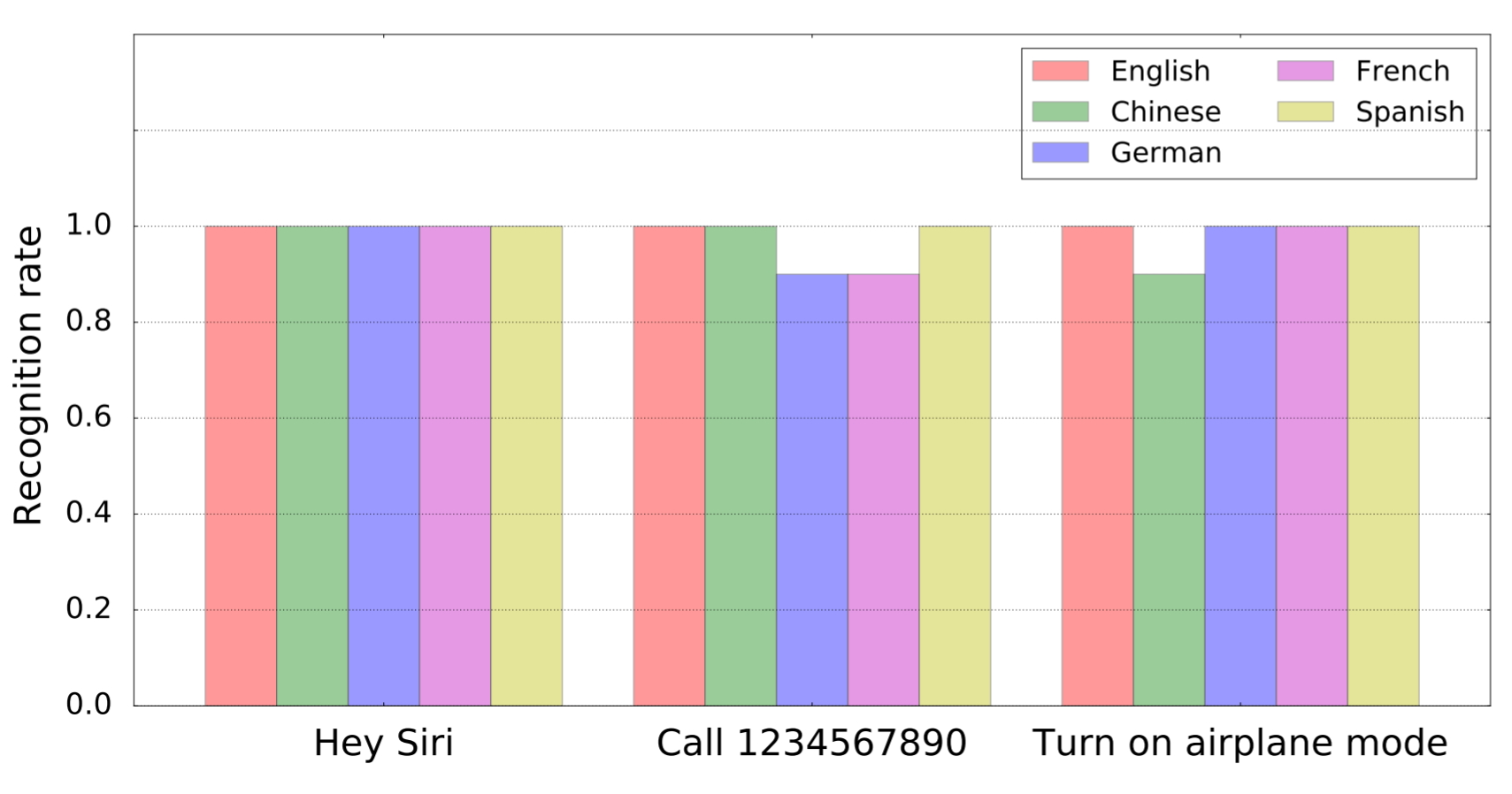

وكجزء من البحث، اتضح أن جميع المساعدات في السوق يستجيبن بشكل أساسي لمثل هذه الأوامر المعدلة. سواء كان ذلك Siri أو Alexa أو Google Assistant أو Samsung S Voice. ولم يكن للجهاز الذي تم اختباره أي تأثير على نتيجة الاختبار. لذلك تم تلقي رد فعل المساعدين من الهاتف ومن الكمبيوتر اللوحي أو الكمبيوتر. على وجه التحديد، تم اختبار أجهزة iPhone وiPad وMacBooks وGoogle Nexus 7 وAmazon Echo وحتى Audi Q3. في المجموع، كان هناك 16 جهازًا و7 أنظمة مختلفة. تم تسجيل أوامر الموجات فوق الصوتية من قبل الجميع. ولعل الأمر الأكثر رعبًا هو حقيقة أن الأوامر المعدلة (وغير المسموعة للأذن البشرية) تم التعرف عليها أيضًا من خلال وظيفة التعرف على الكلام.

تم استخدام العديد من الإجراءات في الاختبارات. بدءًا من أمر بسيط لطلب رقم، وحتى فتح صفحة تم إملاءها أو تغيير إعدادات معينة. وكجزء من الاختبار، كان من الممكن أيضًا تغيير وجهة الملاحة في السيارة.

والخبر الإيجابي الوحيد حول هذه الطريقة الجديدة لاختراق الجهاز هو أنها تعمل حاليًا على مسافة متر ونصف إلى مترين تقريبًا. سيكون الدفاع صعبًا، لأن مطوري المساعدين الصوتيين لن يرغبوا في الحد من ترددات الأوامر التي يتم استشعارها، لأن هذا قد يؤدي إلى وظيفة أسوأ للنظام بأكمله. ولكن في المستقبل، لا بد من إيجاد حل ما.

مصدر: التقنية بلا حدود

وبما أنك تقوم بترجمة المقال، كان بإمكانك جعله أكثر قابلية للفهم. من النسخة الإنجليزية الأصلية، فإن كيفية عملها أقل إرباكًا بكثير. الدفاع أمر تافه، فقط تجاهل الأوامر التي تأتي فقط على الترددات فوق الصوتية.

نعم، وكما هو مذكور في المقال، لن يستمر المطورون في تجاهل الأوامر الصادرة عن الترددات فوق الصوتية، حيث أنه ليس من الواضح تمامًا كيف سيؤثر ذلك على الجودة الناتجة وقدرات التعرف على الأوامر الصوتية الكلاسيكية.

لا، المقال يقول بقطع الطيف. اقترحت تجاهل المدخلات، والتي تتكون فقط من الجزء بالموجات فوق الصوتية من الطيف.